Cursor AI 이제 안녕! VS Code, DeepSeek R1, Ollama 무료 대체 솔루션

유료 AI 코딩 어시스턴트 중에는 Cursor, Windsurf, GitHub Copilot 등 정말 괜찮은 툴들이 있습니다. 하지만 매달 나가는 구독료가 다소 부담되는것도 사실입니다.

오늘은 VS Code Cline 익스텐션 + ollama + DeepSeek R1 조합으로 AI 편집기 무료로 사용하는법을 적어봅니다.

Cline은 VS Code에서 사용할 수 있는 AI 코딩 어시스트 확장 프로그램입니다. 오픈소스로 솔루션이며, 사용자의 명령어나 코드 작성을 도와주는 다양한 기능을 제공하여 개발 생산성을 향상시키는 데 많은 도움을 줄수 있습니다.

비슷한 기능을 제공하는 VS code 확장 프로그램에는 Continue, Roo Code 등이 있으며, 전부 어느정도 검증이 된 프로그램들이며 커뮤니티도 상당히 활성화 되어 있습니다.

기본적인 설정방식은 크게 차이가 없어, 개인 사용습관에 맞는 프로그램을 선택해서 사용하시면 됩니다. 참고로 Cline은 Tab 자동완성 기능이 없어 Cline에 Continue 결합해서 사용하는것도 하나의 옵션입니다.

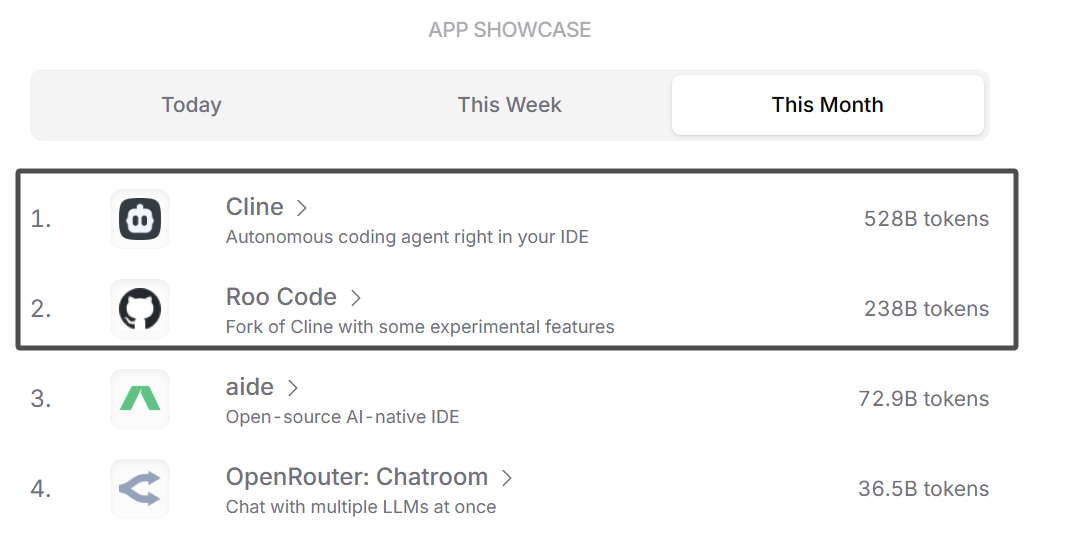

참고로 openrouter.ai 플랫폼 토큰 사용순위를 보면 Cline, Roo Code 토큰 사용량이 압도적으로 높습니다.

Cline,

Continue

Roo Code (prev. Roo Cline)

DeepSeek R1 로컬 실행

왜 로컬 실행인가?

- 무료 및 저비용 운영: Cursor AI는 월 구독료가 발생하는 반면, Cline은 오픈 소스로 제공되며 DeepSeek R1 또한 로컬에서 실행할 수 있으므로 추가 비용 없이 강력한 AI 보조 기능을 활용할 수 있습니다.

- 데이터 보안: 모든 AI 연산이 로컬 환경에서 이루어지므로 코드와 관련 데이터가 외부 서버로 전송되지 않아 프라이버시와 보안 면에서 큰 장점을 제공합니다.

- 빠른 응답 속도: DeepSeek R1은 사용자의 하드웨어에서 직접 실행되기 때문에 네트워크 지연 없이 빠른 응답을 제공하며, API호출방식에 비해 더 낮은 지연시간을 기대할 수 있습니다.

물론 개인 PC에서 실행 가능한 경량화 distilled 모델에서 API가 제공하는 full 파라미터 모델과 같은 효과를 기대하면 안 됩니다.

솔직히 대부분 개인 개발자 분들에게는 어느 정도 비용을 감수하면서 플랫폼에서 제공되는 API를 이용하는 것이 더 현실적이며(특히 한국어와 같이 소수 언어를 사용하는 경우), 로컬 방식의 실행은 실험적인 마인드로 접근해 보시길 바랍니다.

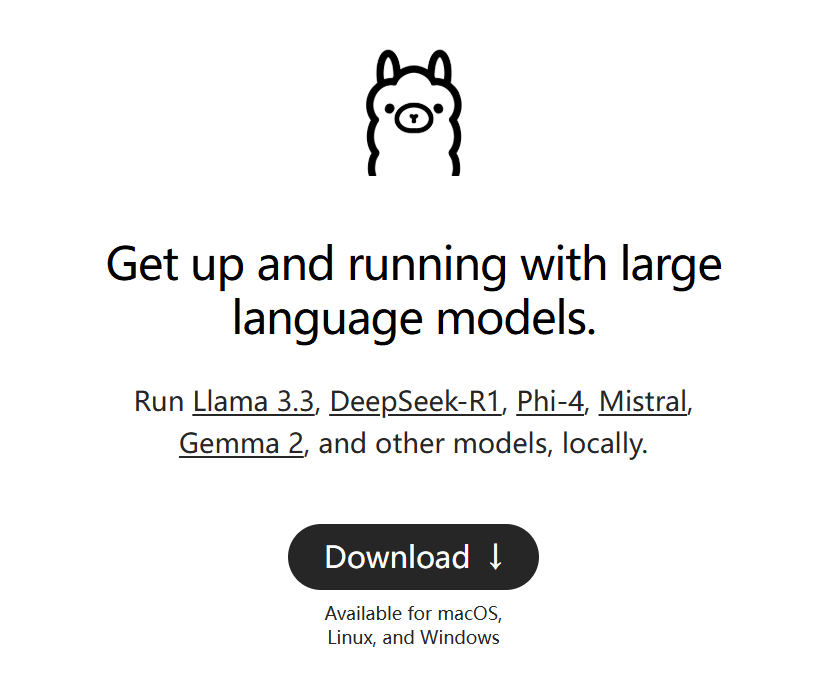

Ollama 설치

Ollama는 DeepSeek R1과 같은 대형 언어 모델을 로컬에서 간편하게 실행할 수 있도록 돕는 도구입니다.

- Ollama 공식 웹사이트에서 Ollama를 다운로드 및 설치합니다.

원하는 DeepSeek R1 모델 다운로드

본인 PC사양에 맞는 모델을 선택하여 다운로드 합니다.

예) 7b 모델의 경우:

# https://ollama.com/library/deepseek-r1 참고.

# ollama run deepseek-r1:1.5b

ollama run deepseek-r1:7b

# ollama run deepseek-r1:8b

# ollama run deepseek-r1:14b

# ollama run deepseek-r1:32b

# ollama run deepseek-r1:70b

모델 다운로드가 끝나면 아래와 같이 로컬에서 자동실행 됩니다.

pulling manifest

pulling 96c415656d37... 100% ▕████████████████████████████████████████████████████████▏ 4.7 GB

pulling 369ca498f347... 100% ▕████████████████████████████████████████████████████████▏ 387 B

pulling 6e4c38e1172f... 100% ▕████████████████████████████████████████████████████████▏ 1.1 KB

pulling f4d24e9138dd... 100% ▕████████████████████████████████████████████████████████▏ 148 B

pulling 40fb844194b2... 100% ▕████████████████████████████████████████████████████████▏ 487 B

verifying sha256 digest

writing manifest

success

>>> hello?

<think>

</think>

Hello! How can I assist you today? 😊

>>>

로컬 실행된 모델은 http://localhost:11434 로 접근할 수 있습니다.

VS Code, Cline 설정

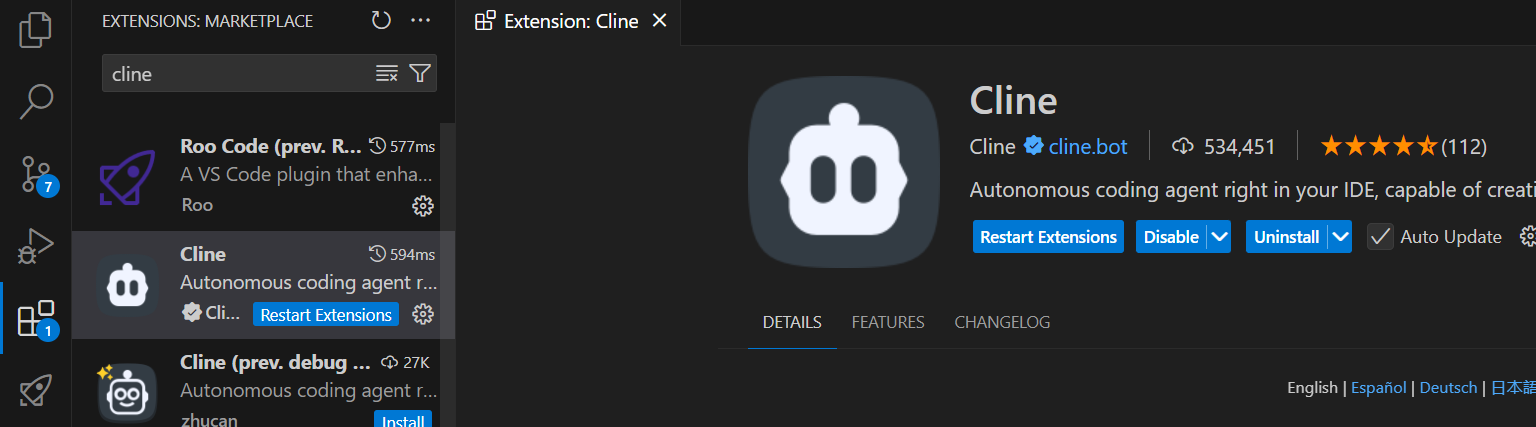

VS Code 확장 프로그램 설치

VS Code 확장 마켓에서 Cline을 검색해 설치합니다.

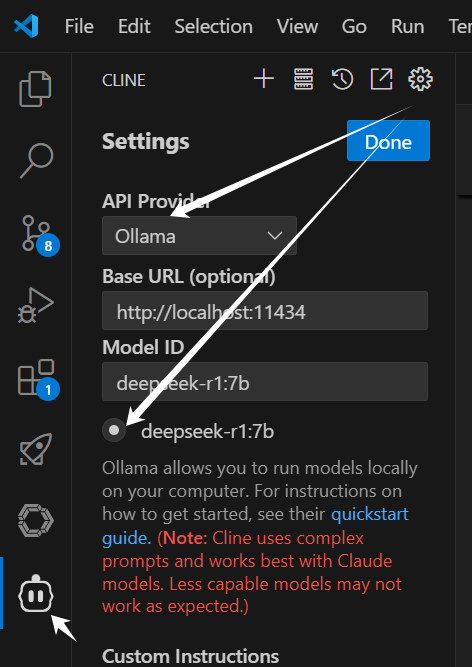

Cline에서 ollama(로컬 Deepseek R1) 연동

- VS Code에서 Cline 설정을 엽니다.

- API Provider 목록에서

Ollama을 선택합니다. Base URL필드에 http://localhost:11434를 입력하고, 모델 선택 옵션에서 실행 중인 DeepSeek R1모델 (예:deepseek-r1:14b)을 선택합니다.

로컬 DeepSeek 모델 배포가 성공하면,

Base URL입력 후 Model ID 아래에 자동으로 사용 가능한 모델 선택 창이 표시됨.

메시지 입력후,

MCP hub not available오류가 뜨면 VS code재구동하면 해결됨.

Github Issue 참고: https://github.com/cline/cline/issues/969

테스트

설정이 끝나면 Cline을 이용해 prompt를 입력해 정상��적으로 응답하는지 확인합니다.

prompt 입력후 CPU가 미친듯이 돌아가는데 응답이 너무 느리거나 없으면, 해당 모델을 돌리기에 PC사양이 딸리는 경우입니다..이떄는 모델버전 낮추어 테스트해보길 추천드립니다.

API 연동 방식

- DeepSeek API 키 발급 (DeepSeek 공식 사이트)

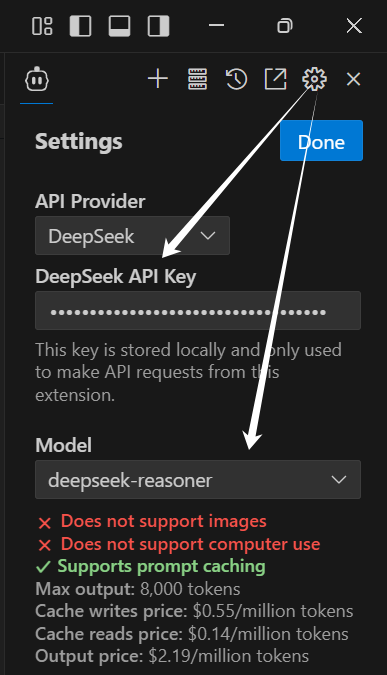

- VS Code에서 Cline 설정을 열어, API Provider 목록에서

DeepSeek를 선택하고 API Key를 입력하고, 모델을deepseek-reasoner를 선택합니다.

이제 여러분도 월 $0으로 Cursor 수준의 AI 코딩을 경험해보세요! 설정 과정에서 문제가 발생하면 Ollama 공식 문서나 Cline GitHub 이슈 페이지에서 도움을 받을 수 있습니다.